Graphcore的智能处理器 (IPU) 是第一个专为机器智能设计的处理器,其IPU硬件和Poplar SDK能够帮助开发者在机器智能方面实现新突破。而作为飞桨重要的硬件合作伙伴,Graphcore将通过云端和数据中心的IPU技术助力我们飞桨的开发者们实现AI模型大幅加速,同时也为使用飞桨的企业提供基于IPU的产品方案,帮助飞桨的企业级客户提升数据中心效率。通过大幅提升模型的性能和运行速度,缩短研发周期,加快AI模型落地应用,同时降低计算成本。

阶段成果

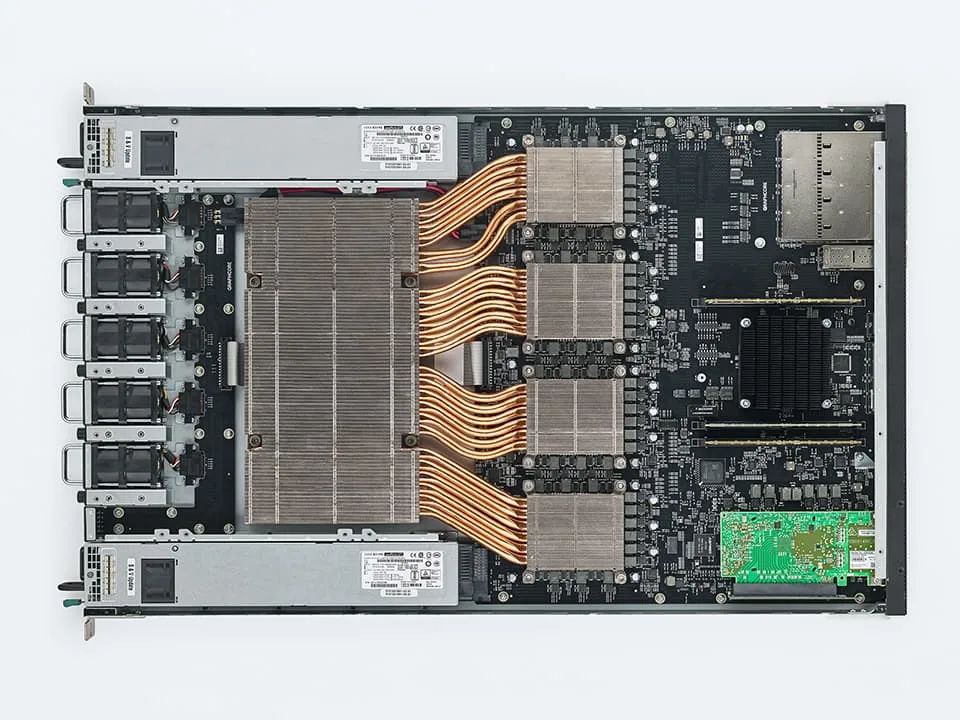

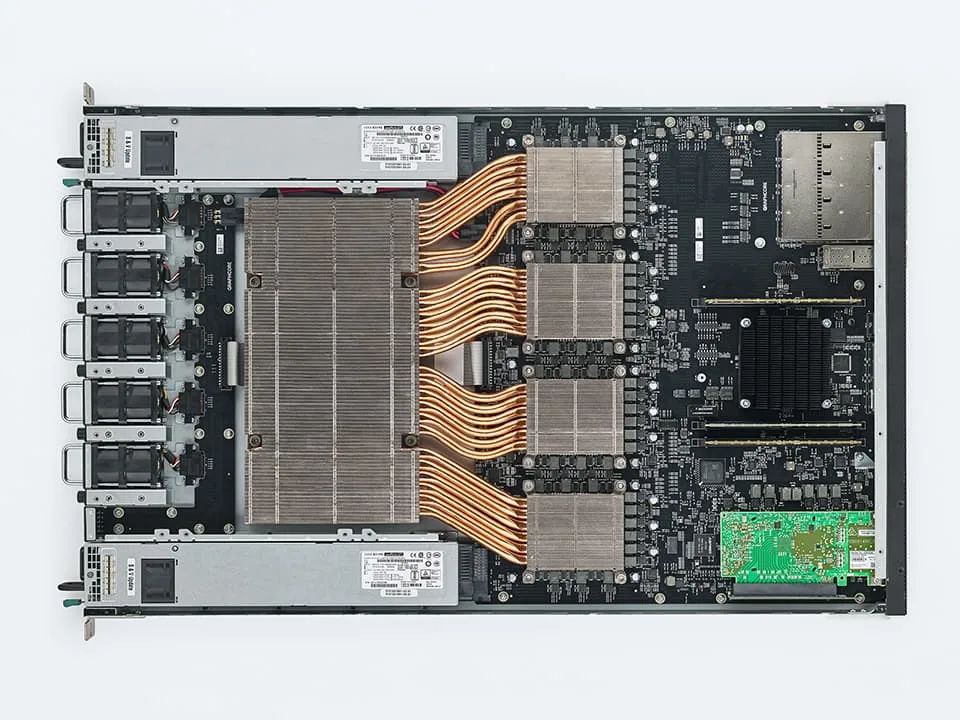

目前Graphcore IPU支持通过飞桨完成大规模的模型训练任务,也支持通过飞桨推理库执行高性能的推理任务。双方团队通过在16个IPU组成的IPU-POD16上做数据并行与模型并行,并在Bert-Base模型上进行了精读和吞吐量验证,取得了良好的性能效果。

结果证明,运行在IPU硬件上的百度飞桨解决方案,在目前主流的AI训练任务和前沿AI创新模型任务上,可以取得很好的加速效果。IPU良好的系统扩展性使得用户可以根据任务需求灵活扩展性能。

适配方案设计

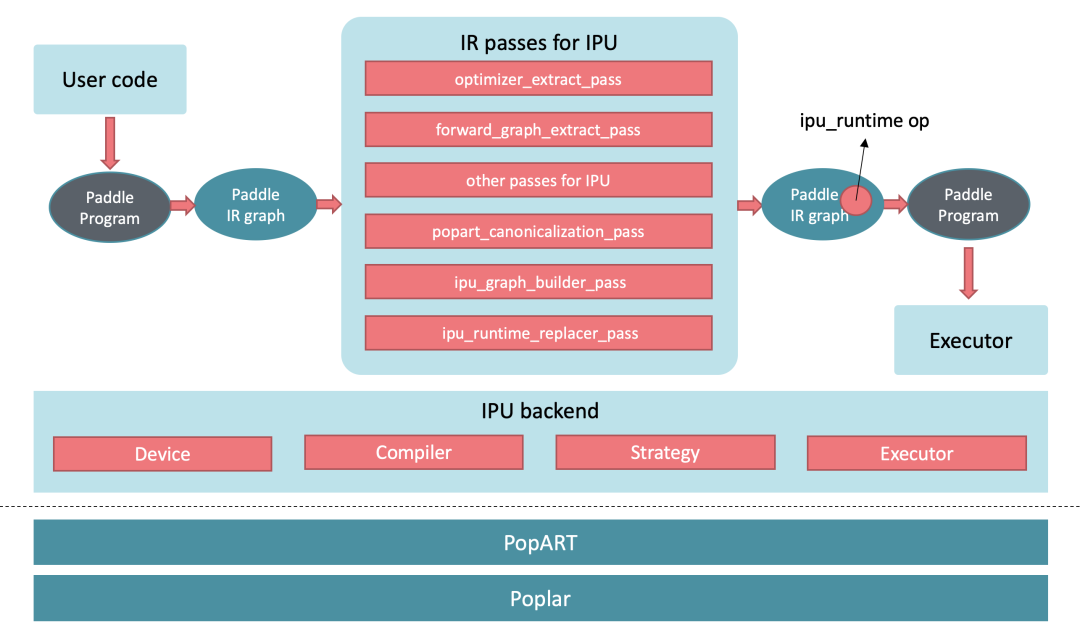

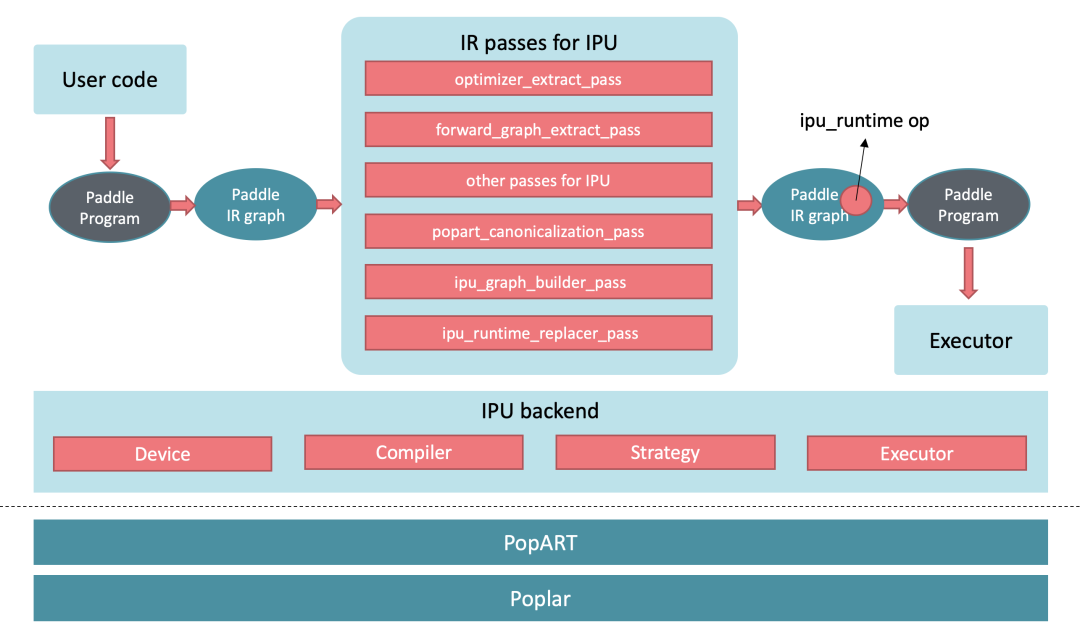

飞桨框架当前支持以算子接入、子图/整图接入以及编译器后端三种方式对接硬件,并且包含定义良好的IR(Intermediate Representation),以及用于做图优化的IR Pass机制。飞桨框架同时也通过扩展新的Device类型、Operator、Pass、Executor等机制,使框架拥有良好的扩展性,方便开发者来支持新的硬件类型。

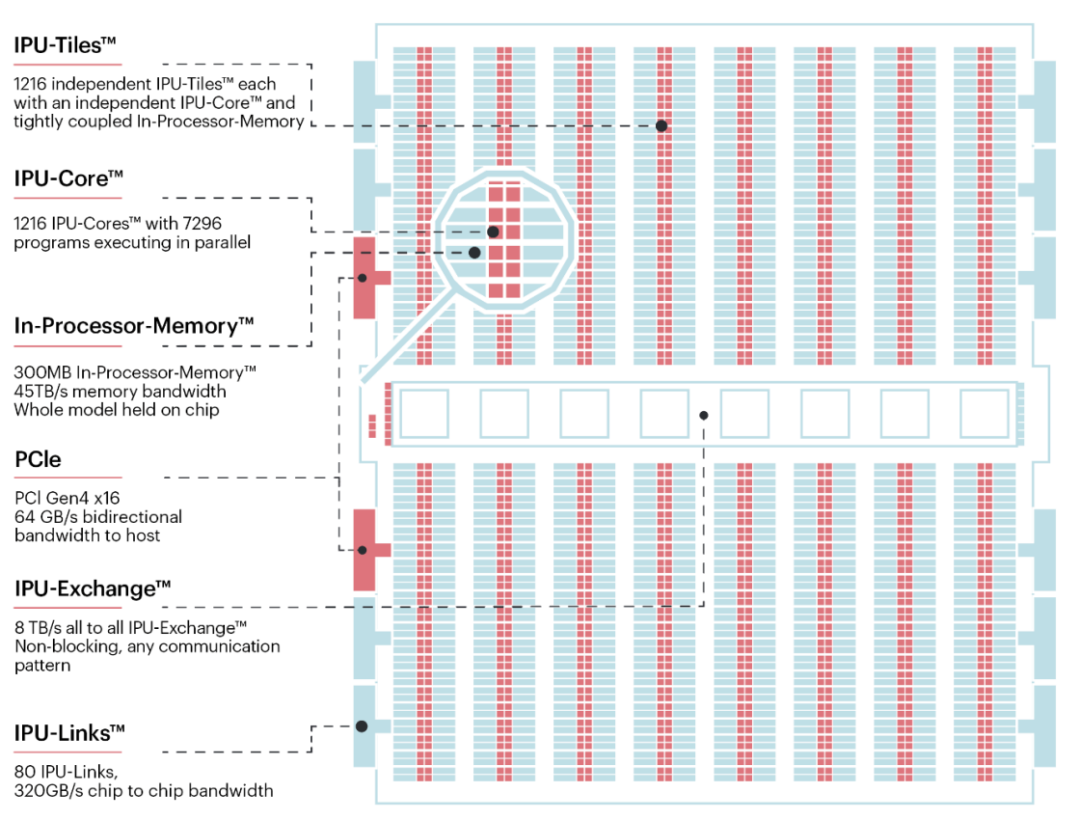

Graphcore IPU深入解读

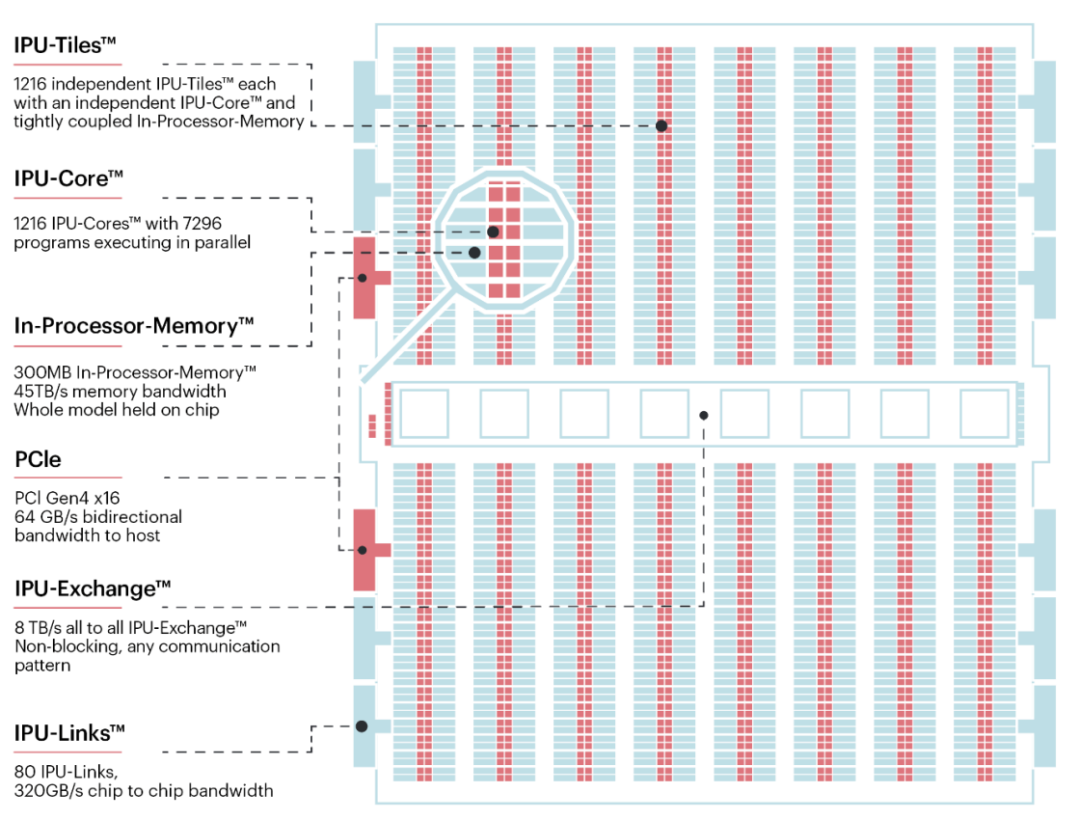

Graphcore的IPU的设计目标是解决大多数ASIC和GPU中存在的那些当前加速架构无法解决的问题。这些芯片通常是针对密集的线性代数工作负载进行特定优化的,这些工作负载或许可以在某些卷积神经网络中较为高效的执行,但却不太适合更加变化多样的数据访问模式。

Graphcore的智能处理器 (IPU) 是第一个专为机器智能设计的处理器,其IPU硬件和Poplar SDK能够帮助开发者在机器智能方面实现新突破。而作为飞桨重要的硬件合作伙伴,Graphcore将通过云端和数据中心的IPU技术助力我们飞桨的开发者们实现AI模型大幅加速,同时也为使用飞桨的企业提供基于IPU的产品方案,帮助飞桨的企业级客户提升数据中心效率。通过大幅提升模型的性能和运行速度,缩短研发周期,加快AI模型落地应用,同时降低计算成本。

阶段成果

目前Graphcore IPU支持通过飞桨完成大规模的模型训练任务,也支持通过飞桨推理库执行高性能的推理任务。双方团队通过在16个IPU组成的IPU-POD16上做数据并行与模型并行,并在Bert-Base模型上进行了精读和吞吐量验证,取得了良好的性能效果。

结果证明,运行在IPU硬件上的百度飞桨解决方案,在目前主流的AI训练任务和前沿AI创新模型任务上,可以取得很好的加速效果。IPU良好的系统扩展性使得用户可以根据任务需求灵活扩展性能。

适配方案设计

飞桨框架当前支持以算子接入、子图/整图接入以及编译器后端三种方式对接硬件,并且包含定义良好的IR(Intermediate Representation),以及用于做图优化的IR Pass机制。飞桨框架同时也通过扩展新的Device类型、Operator、Pass、Executor等机制,使框架拥有良好的扩展性,方便开发者来支持新的硬件类型。

Graphcore IPU深入解读

Graphcore的IPU的设计目标是解决大多数ASIC和GPU中存在的那些当前加速架构无法解决的问题。这些芯片通常是针对密集的线性代数工作负载进行特定优化的,这些工作负载或许可以在某些卷积神经网络中较为高效的执行,但却不太适合更加变化多样的数据访问模式。